在新兴的人工智能 (AI) 领域,对道德考虑和公平的关注不仅仅是一种道德要求,也是该技术的长寿和社会接受度的基本必要条件。道德人工智能或公平人工智能是为了确保人工智能系统的运行没有偏见、歧视或不公正的结果。本博客探讨了道德人工智能的重要性,并深入探讨了需要避免的各种类型的偏见。

为什么人工智能道德很重要

人工智能系统正日益成为我们日常生活的一部分,其决策影响着从工作申请到司法判决的方方面面。当这些制度存在偏见时,它们可能会延续并扩大社会不平等,对个人和群体造成伤害。道德人工智能旨在通过促进公平、问责、透明度和尊重人权来防止此类结果。

偏见的类型和例子

暴力偏见

人工智能系统必须经过训练才能识别和忽略暴力内容。例如,接受暴力文本训练的语言模型可能会生成有害内容,从而促进攻击性而不是建设性对话。

争议话题

在没有仔细调节的情况下就有争议的话题训练人工智能可能会导致人工智能采取两极分化的立场。例如,接受枪支权利数据训练的人工智能可能会产生有争议的片面论点。

性别偏见

性别偏见的一个典型例子是,语言模型将护士与女性、工程师与男性联系起来,强化了过时的刻板印象,而不是反映这些职业的多样性。

种族和民族偏见

考虑一个人工智能,它生成首席执行官的图像,但主要将他们描述为属于单一种族群体,从而忽略了企业界多样性的现实。

社会经济偏见

人工智能系统可能偏爱与较高社会经济地位相关的语言或概念,例如假设奢侈品牌是质量标准,而忽视了更广泛的消费者体验。

年龄偏见

人工智能可能会错误地认为技术的提及与老年人无关,从而将他们排除在有关数字进步的对话之外。

文化偏见

人工智能系统可能会生成专注于西方美食的餐厅评论,而忽视其他烹饪传统的丰富性,从而边缘化非西方文化。

政治偏见

被编程来策划新闻文章的人工智能可能会不成比例地从政治光谱的左端或右端选择文章,而不是呈现平衡的观点。

宗教偏见

如果人工智能系统不成比例地积极地引用一种宗教,而忽视或歪曲其他宗教,那么它就会表现出宗教偏见。

区域偏见

语言模型可能会生成仅与城市地区相关的交通报告,而忽略农村或人口较少的地区。

残疾偏见

考虑一个人工智能健康顾问无法为残疾人提供无障碍的锻炼选择,从而提供不完整和排他性的建议。

语言偏见

翻译人工智能可能会始终为某些语言提供高质量的翻译,但对于训练数据中代表性较少的语言,翻译质量可能会较差。

确认偏差

人工智能可能会选择性地引用支持该补救措施的来源并忽略科学共识,从而增强用户对错误补救措施的信念。

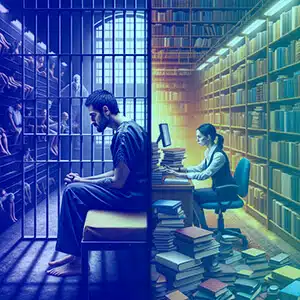

情境偏见

人工智能可能会将有关“监狱”信息的请求解释为刑事调查,而不是学术或法律调查,具体取决于它接受训练的背景。

数据源偏差

如果人工智能的训练数据来自主要讨论特定人群成就的论坛,它可能会忽略其他群体的贡献。

如何避免这些偏见

避免这些偏见需要采取多方面的方法:

- 多样化的数据集: 整合广泛的数据源以平衡不同群体之间的代表性。

- 定期审核: 进行持续检查以识别并纠正偏见。

- 透明度: 明确人工智能系统如何做出决策以及它们接受哪些数据的训练。

- AI 团队的包容性: 多元化的团队可以更好地识别可能被忽视的潜在偏见。

- 道德培训: 教育人工智能开发人员了解道德考虑的重要性。

- 利益相关者反馈: 让用户和受影响的社区参与人工智能开发过程。

为什么选择

Shaip 作为人工智能数据解决方案的领导者,提供全面的服务,旨在正面解决人工智能偏见问题。通过为训练人工智能模型提供多样化且平衡的数据集,Shaip 可确保您的人工智能系统接触广泛的人类经验和人口统计数据,从而降低从性别和种族到语言和残疾等各个方面的偏见风险。他们严格的数据管理和注释流程,加上符合道德的人工智能框架,可以帮助组织识别、减轻和防止将偏见纳入人工智能系统。 Shaip 在开发定制模型方面的专业知识也意味着他们可以协助创建尽可能包容、公平和公正的人工智能,并符合道德人工智能的全球标准。

结论

道德人工智能对于创造一个技术不带偏见地服务人类的未来至关重要。通过理解和减少偏见,开发人员和利益相关者可以确保人工智能系统的公平和公正。参与人工智能生命周期的每个人都有责任营造一个技术反映我们最高道德标准的环境,促进公正和包容的社会。通过对这些原则保持警惕和奉献,人工智能可以发挥其作为正义力量的真正潜力。